IA de Boa – A máscara da saúde digital: o perigo oculto nas plataformas médicas sem rosto

Novo quadro em destaque: Infância Protegida

Jamille Porto (advogada) e Carolina Pisano (psicóloga) unem suas visões — jurídica e emocional — para alertar sobre os riscos e caminhos para garantir a segurança infantil na era digital.

Traz ainda entrevistas exclusivas e análises essenciais sobre como a Inteligência Artificial pode transformar — ou colocar em risco — a vida das pessoas.

Por Inez Pinheiro Araújo

Jornalista, estrategista em comunicação e especialista em Inteligência Artificial aplicada.

Apaixonada por gente, histórias e pelo impacto transformador da tecnologia no nosso dia a dia.

Sobre a Coluna

A IA de Boa é um espaço para descomplicar o universo da inteligência artificial.

Aqui, a tecnologia não é fria nem distante — ela é prática, acessível e cheia de possibilidades para a vida real.

Destaques desta edição

☕ Café com IA: A Iara da tecnologia — o canto falso da sereia das plataformas genéricas de atendimento médico.

🛡️ Infância Protegida: Jamille Porto (advogada) e Carolina Pisano (psicóloga) unem suas visões — jurídica e emocional — para alertar sobre os riscos e caminhos para garantir a segurança infantil na era digital.

👤🤖 Entre Agentes & Gente: Conversa com Rafael Castro sobre automação segura e soluções que realmente acompanham o crescimento das empresas.

🤖 IA com Personalidade: Apresentação do Agente Start, criado para captar e engajar clientes de forma humanizada, especialmente para negócios em fase de crescimento.

🔐 Segurança em Foco: Thiago Santos, especialista em segurança digital e parceiro da IP Estratégias, alerta sobre os perigos das plataformas médicas sem rosto.

💉 Sem Anestesia: As plataformas genéricas podem até parecer solução, mas escondem riscos que esmagam confiança, segurança e vidas.

☕ Café com IA

🔹 A Iara da tecnologia: o canto falso da sereia digital

Quem já ouviu falar da lenda da Iara, a sereia que encantava com seu canto e depois afogava navegadores? Pois é. No mundo da Inteligência Artificial também existem “Iaras digitais”: plataformas genéricas que parecem mágicas no começo, mas escondem riscos no caminho.

Elas seduzem com preços acessíveis e promessas de eficiência, mas logo mostram o outro lado: falta de suporte humano, dificuldade de adaptação à identidade da empresa e brechas na segurança de dados. Resultado: um atendimento engessado, distante do que o cliente realmente espera.

👉 Uma solução sob medida, por outro lado, é como um traje feito por alfaiate: respeita a identidade da marca, cresce junto com o negócio e garante segurança de acordo com a LGPD.

No fim, a escolha é clara: cair no canto da sereia ou apostar em valor sustentável. A personalização aliada ao suporte humano é o que realmente faz a diferença.

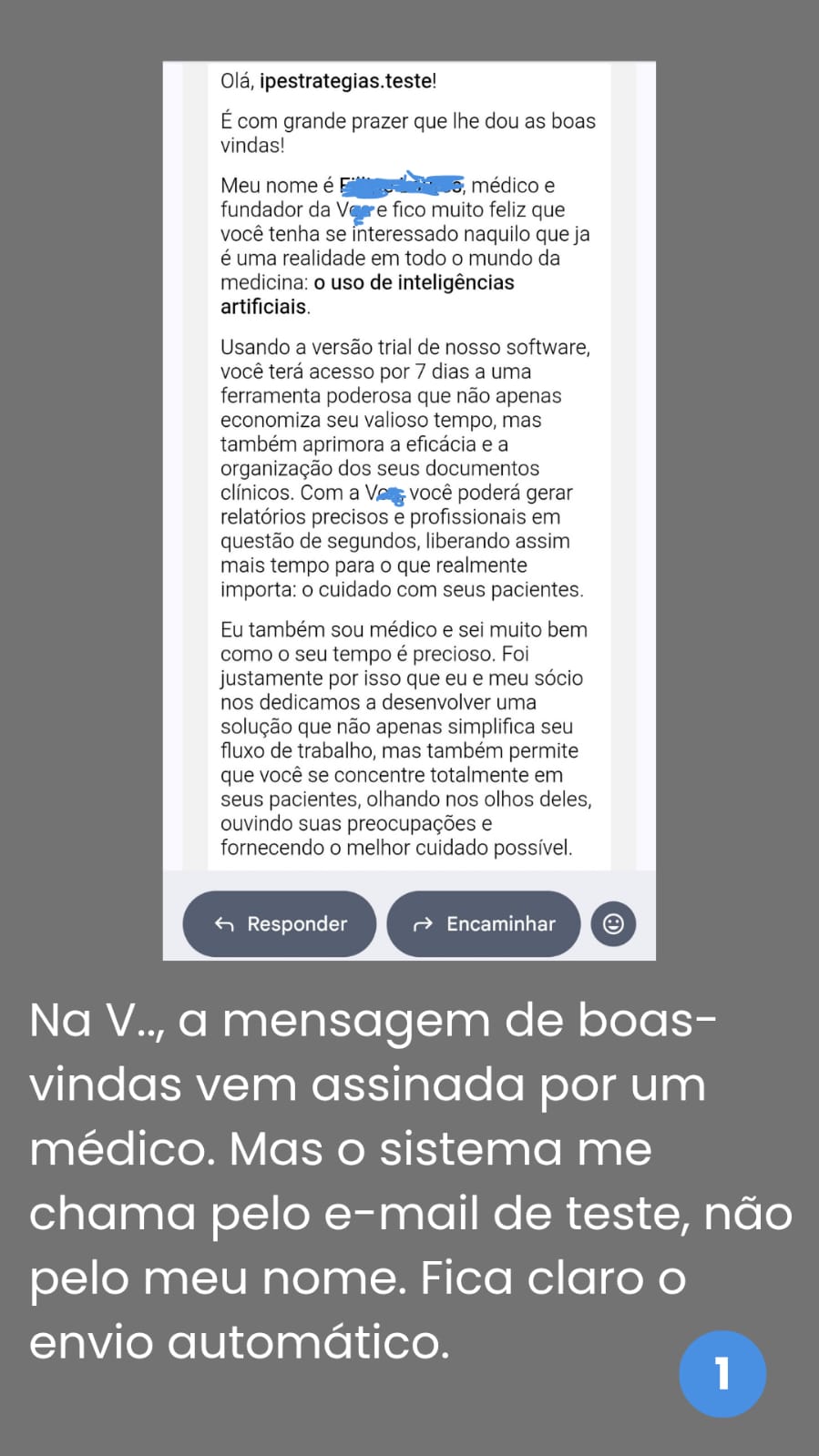

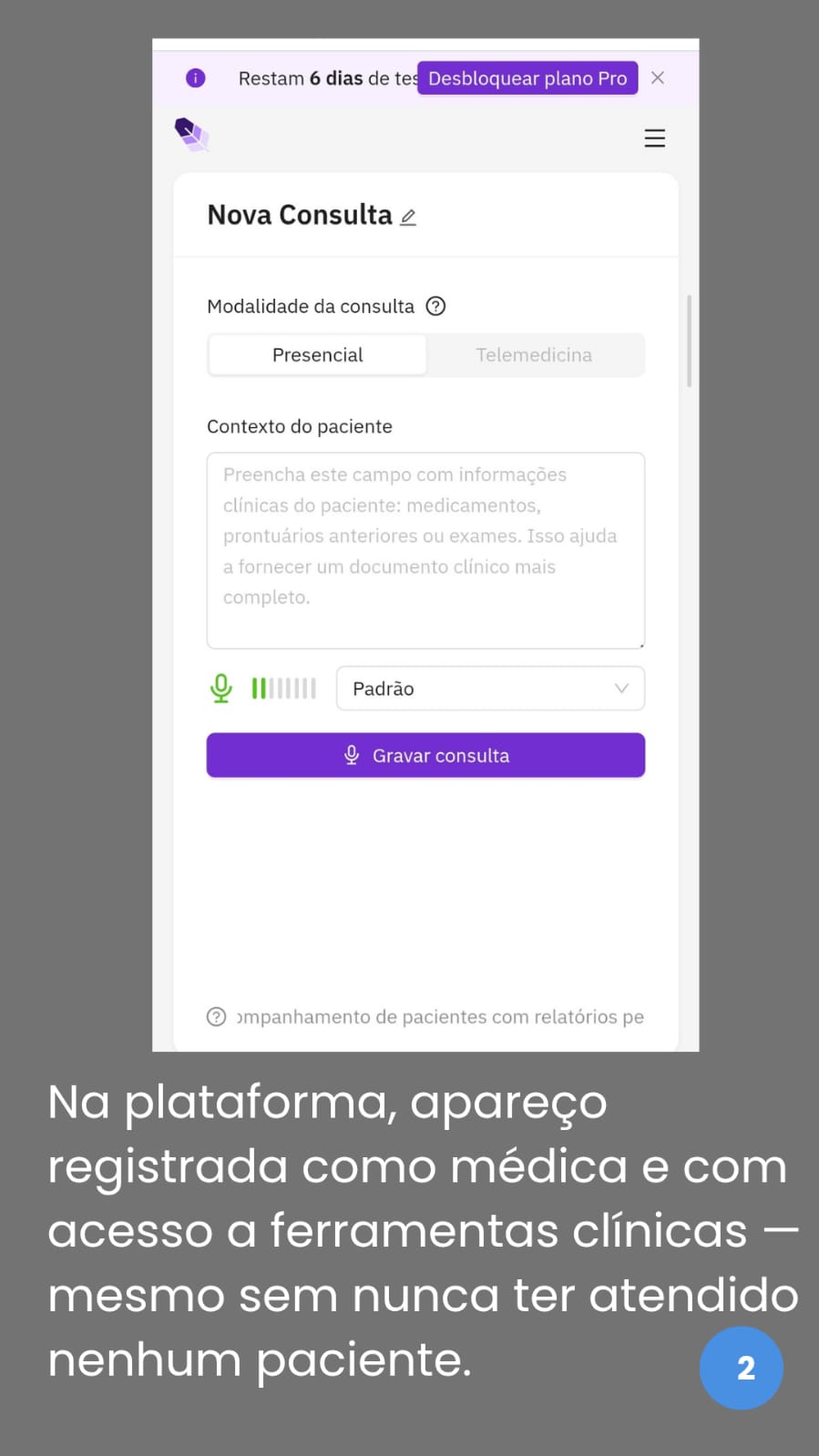

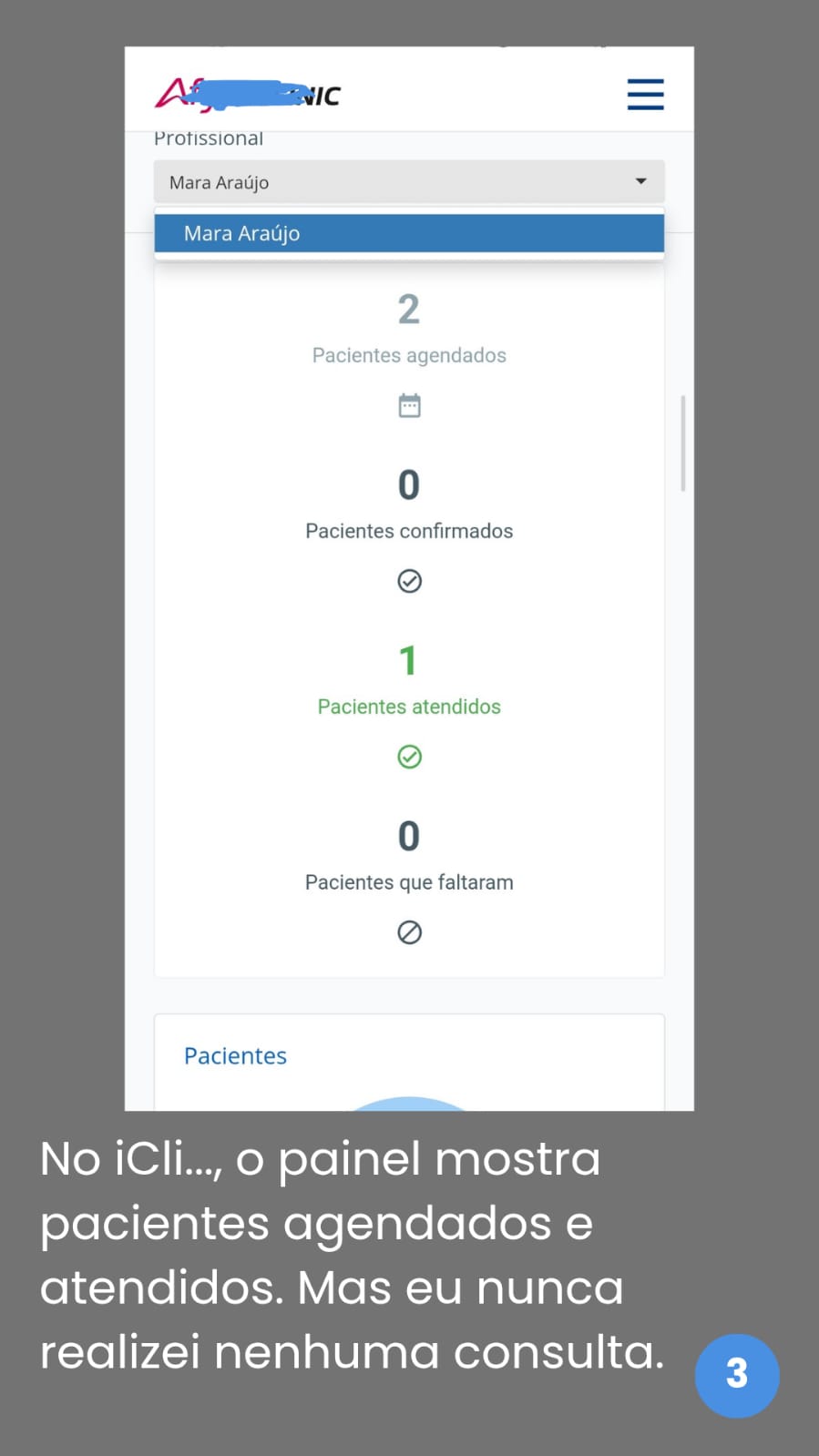

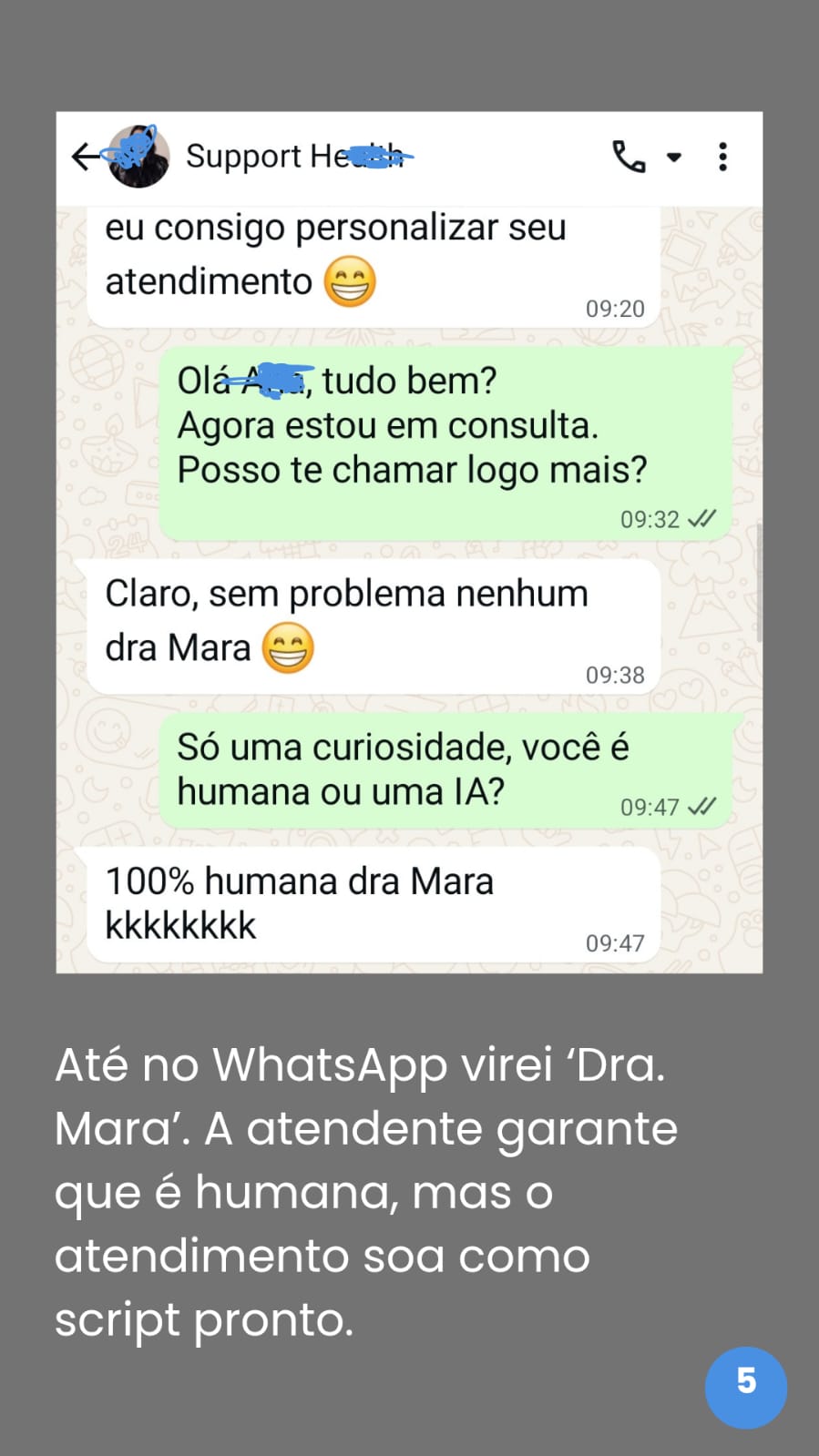

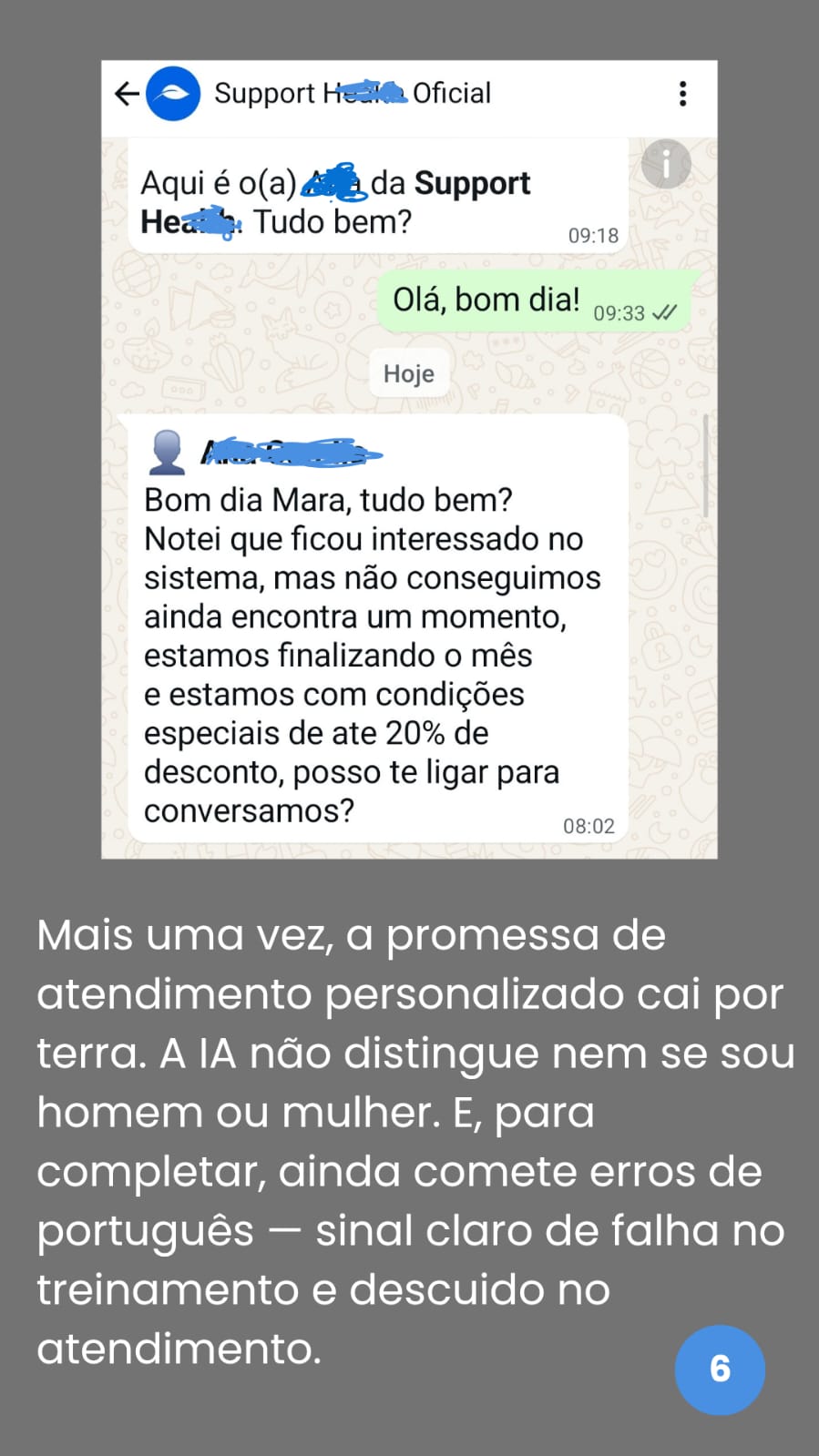

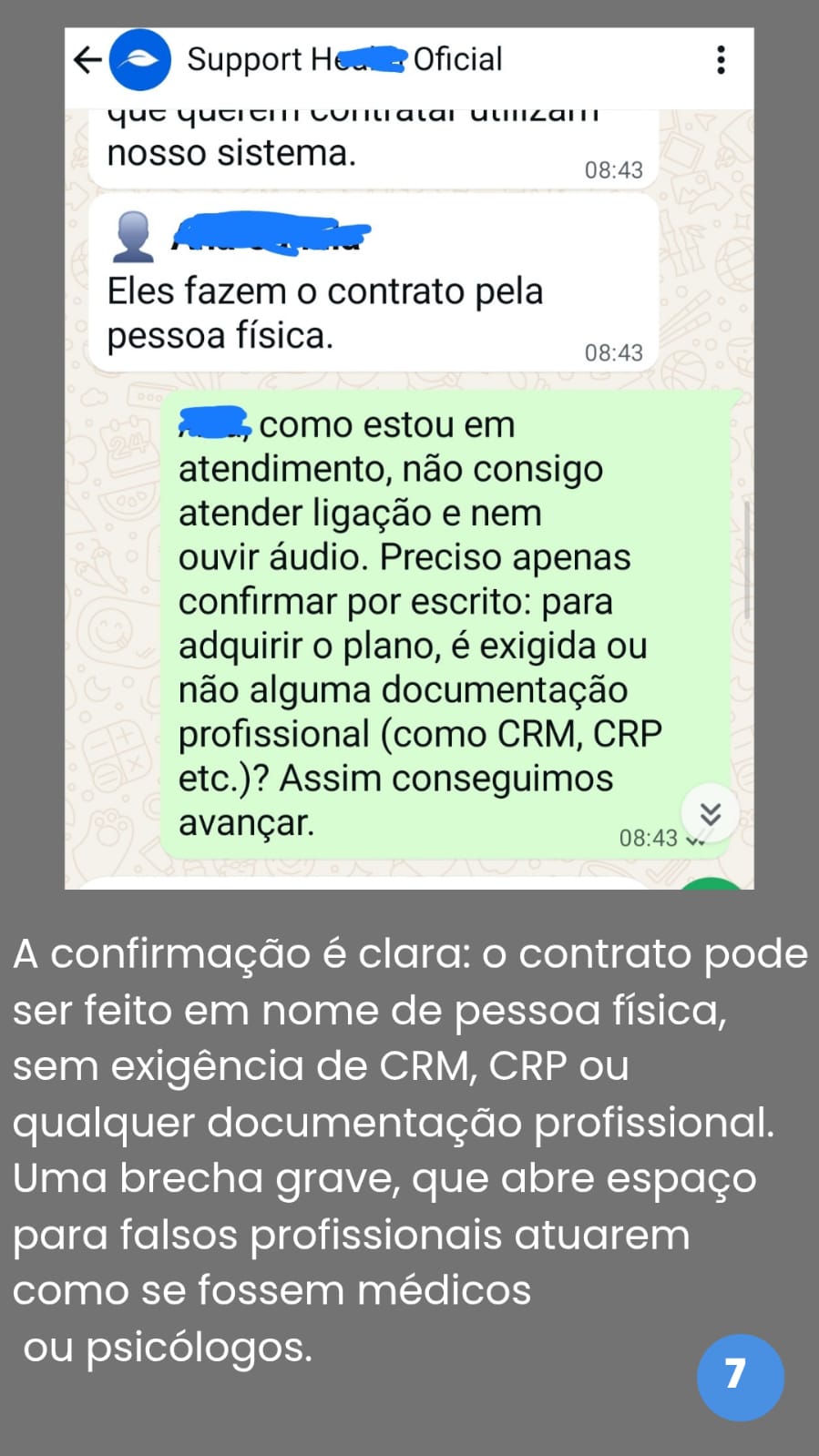

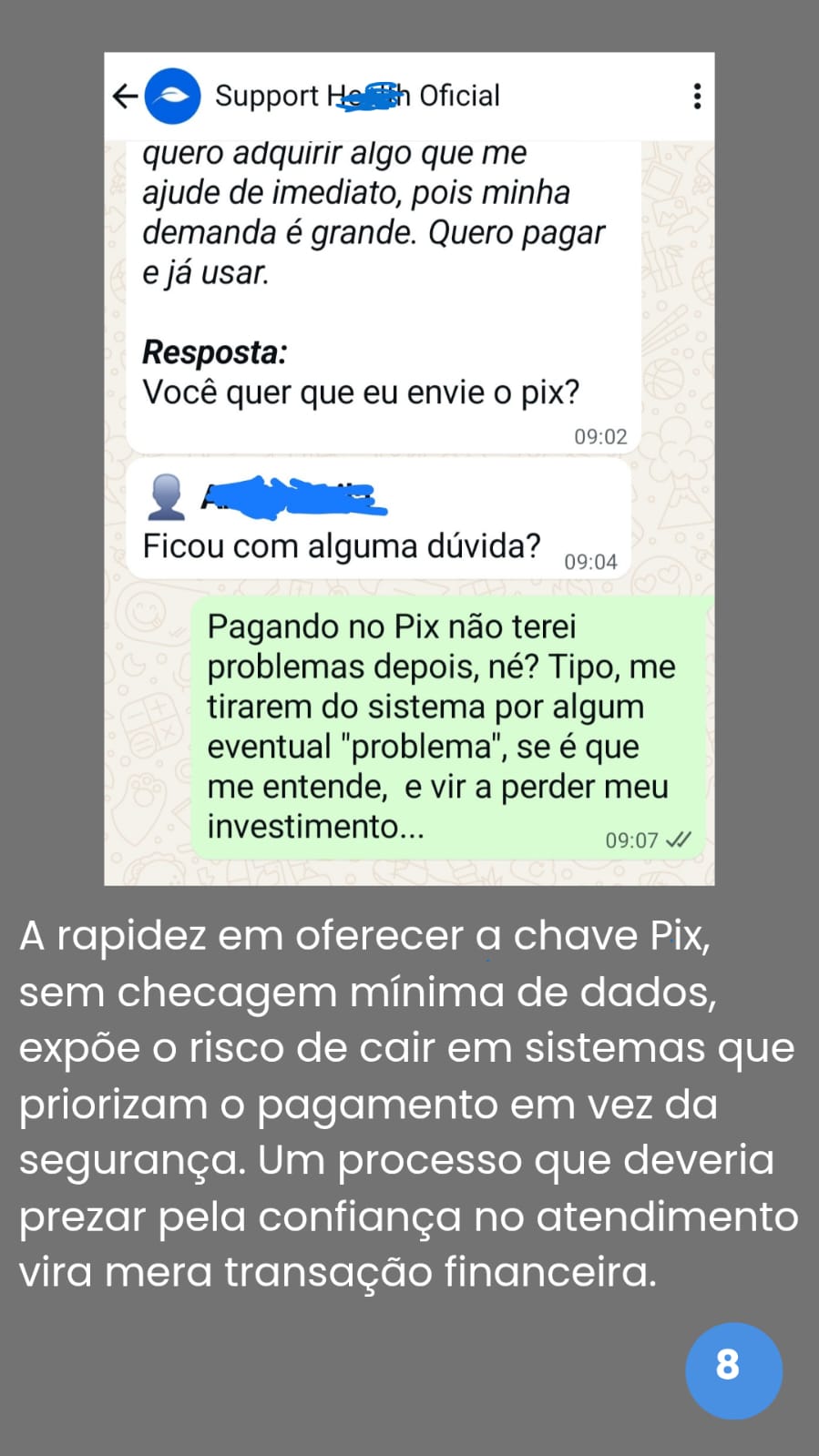

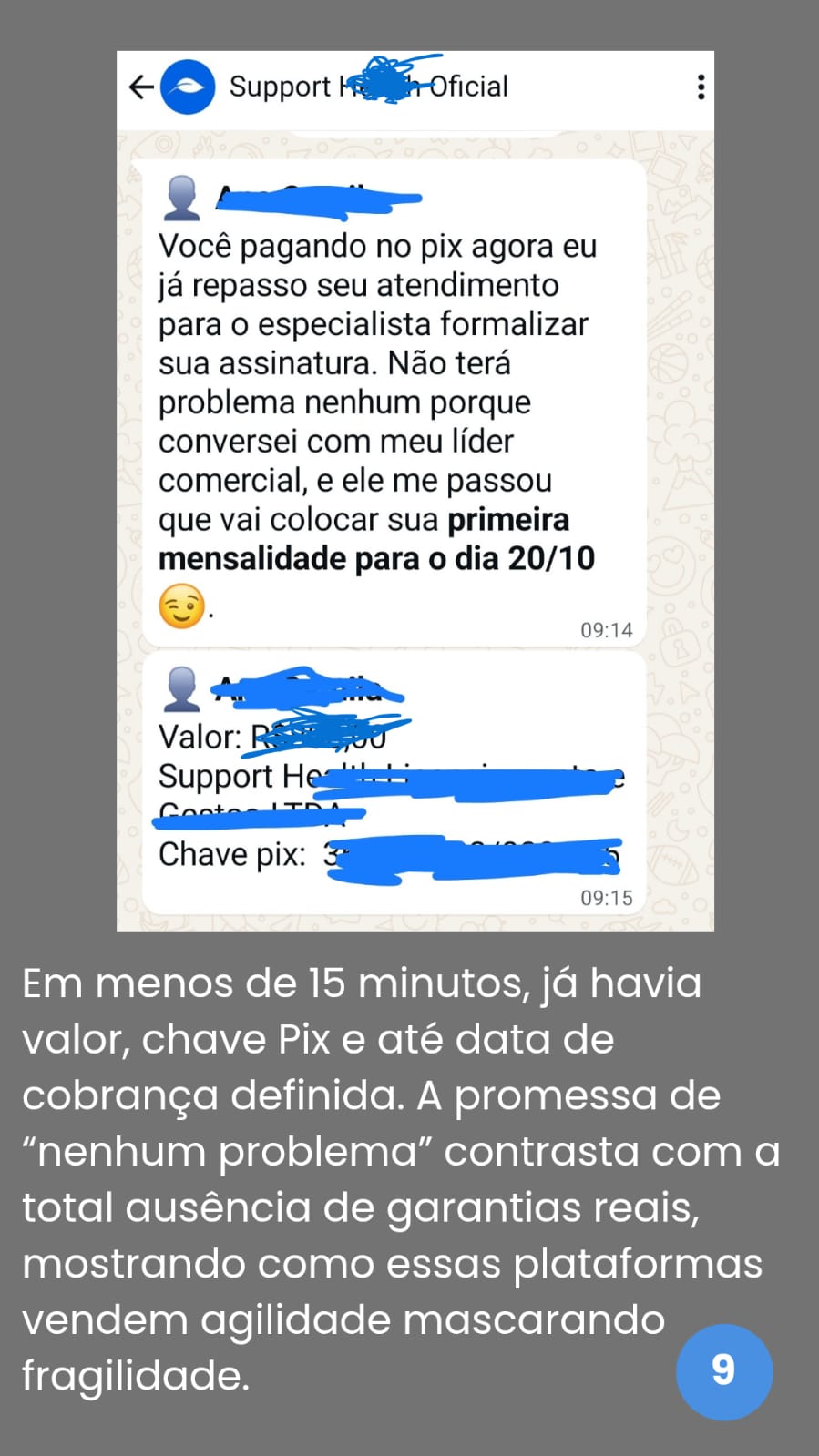

Para provar que qualquer um pode ser “médico digital” nessas plataformas, eu mesma resolvi me cadastrar. Resultado? Virei Dra. Mara Araújo em questão de minutos. Sem diploma, sem CRM, sem entrevista — apenas com um e-mail e alguns cliques.

O que encontrei a seguir é digno de alerta máximo. E é isso que compartilho aqui: o lado obscuro das chamadas soluções “milagrosas” de saúde digital.

Os prints acima não são apenas registros visuais. Eles revelam, na prática, como algumas plataformas falham em entregar o que prometem. Cada número é um detalhe que expõe a distância entre o discurso e a realidade — e mostra por que a supervisão humana continua sendo insubstituível.

Investir em uma solução customizada é garantir identidade, segurança e continuidade. É deixar de ser “mais um” em uma vitrine genérica e passar a proteger sua clínica, seu paciente e suas rotinas. No médio prazo, isso significa menos retrabalho e menos riscos legais.

🃏 Besta Seller – “Consulta pausada”

Era para ser uma simples olhadinha na plataforma. Cliquei em “teste grátis”, e pronto: virei paciente sem querer. Conversando com a minha mãe, rindo e dizendo besteira, meu filho lá atrás soltando palavrão, e o sistema registrando tudo como se fosse prontuário oficial.

Resultado: diagnóstico da consulta? “Paciente apresenta fala confusa e quadro de rebeldia adolescente no ambiente familiar.”

Se fosse em outra época, ia virar piada de corredor. Mas em tempos de inteligência artificial sem filtro, vira prontuário.

E eu só pensei: gente… se até eu, que sei investigar, caí nesse “consultório fake”, imagina quem confia de olhos fechados?

É por essas e outras que eu digo: a tecnologia é ótima, mas quando a piada entra no prontuário, o Besta Seller já está garantido.

🛡️ Infância Protegida

Especial com Jamille Porto (Advogada e Professora de Direito Digital e IA) e, na sequência, Carolina Pisano (Psicóloga clínica e jurídica, especialista em neuropsicologia e em práticas inclusivas, mestra em Educação. Ambas analisam como a Inteligência Artificial impacta a vida das crianças — e o que pais, educadores e a sociedade precisam fazer para garantir um futuro digital mais seguro.

Jamille Porto – Advogada e Professora de Direito Digital e Inteligência Artificial

Nesta edição, trazemos uma reflexão essencial sobre segurança infantil no ambiente digital. Jamille Porto compartilha uma visão crítica sobre os riscos, os desafios da legislação e os caminhos para equilibrar tecnologia e proteção das crianças.

IA de Boa: No cenário atual, em que crianças têm contato tão cedo com tecnologia e redes sociais, quais são os principais riscos que você enxerga no uso da Inteligência Artificial por esse público?

Jamille Porto:

O maior risco não está só no que a criança vê, mas no que a inteligência artificial aprende sobre ela. Cada clique, cada segundo que ela passa em um vídeo, cada palavra que escreve em um chat é convertido em dados. Esses sinais permitem que o sistema construa um perfil detalhado: o que prende sua atenção, seus medos, suas preferências, até padrões de humor e horários de uso. A partir daí, a IA começa a ajustar o que recomenda para mantê-la conectada, explorando vulnerabilidades emocionais em uma fase em que ela ainda não sabe separar uma sugestão inocente de uma manipulação perigosa.

Essa coleta e esse aprendizado não desaparecem com um simples “apagar conta”. Parte do que foi aprendido permanece nos modelos e continua influenciando recomendações e decisões, mesmo quando a família acha que encerrou a exposição. Um exemplo real mostra como isso já acontece: em dezembro de 2024, a Autoridade Nacional de Proteção de Dados proibiu o X, antigo Twitter, de usar dados de crianças e adolescentes brasileiros para treinar sua inteligência artificial, depois de descobrir que a coleta era feita automaticamente, sem consentimento específico.

Esse episódio evidencia algo que muitos pais desconhecem: enquanto a criança navega, a IA vai mapeando e prevendo seu comportamento, ajustando cada recomendação para que ela passe mais tempo na plataforma. O objetivo comercial é claro: manter a criança conectada o máximo possível, independente de o conteúdo ser educativo ou prejudicial. O perigo, portanto, não é um vídeo inadequado isolado, mas uma máquina de engajamento que refina continuamente suas estratégias para garantir que ela volte, clique e permaneça.

IA de Boa: Na sua visão, qual deve ser o papel dos pais e responsáveis para proteger as crianças em ambientes digitais?

Jamille Porto:

O papel dos pais não é vigiar em silêncio, mas educar ativamente. A melhor barreira de proteção é um diálogo constante que transforma a criança em alguém capaz de questionar o que vê. Só limitar tempo de tela é insuficiente, porque o problema não é apenas quantidade: é como o algoritmo molda a experiência. É preciso explicar, desde cedo, o que são dados pessoais, por que um vídeo é sugerido, como identificar um conteúdo suspeito e o que fazer quando algo parece estranho.

Isso não significa deixar de usar recursos técnicos. Contas familiares, filtros de idade e alertas de uso devem ser configurados, mas com transparência: a criança precisa saber que essas ferramentas existem e por quê. Caso contrário, ela aprende apenas a driblar as regras.

E não se trata de um medo abstrato. O episódio do X, antigo Twitter, que coletava dados de menores para treinar IA sem consentimento, mostra que nem empresas globais com bilhões em recursos conseguem ou querem se autorregular. Sem diálogo e acompanhamento próximos, a criança se torna matéria-prima invisível para modelos de inteligência artificial.

O dever, portanto, é ensinar a pensar antes de clicar. Conversar diariamente, perguntar o que ela viu, como se sentiu, que dúvidas surgiram. Transformar cada uso de tela em oportunidade de formação crítica. Essa presença consciente é a única forma de proteger de verdade: quando a criança entende a lógica por trás das recomendações, ela não só se defende hoje como leva essa consciência para a vida inteira.

IA de Boa: A legislação brasileira já contempla a proteção de dados das crianças, mas você acredita que ainda há lacunas quando o assunto é Inteligência Artificial?

Jamille Porto:

Sim. A LGPD prevê tratamento diferenciado para dados de menores, mas foi criada antes da explosão da IA generativa e já não dá conta do novo cenário. A lei protege dados “pessoais” (nome, e-mail, CPF), só que a inteligência artificial de hoje não precisa de nada disso para conhecer uma criança. Um histórico de cliques, pausas em vídeos, entonações de voz ou padrões de digitação é suficiente para inferir idade, humor, interesses, fragilidades emocionais e até localização aproximada. Esses perfis comportamentais são gerados sem que os pais saibam e nem sempre se enquadram na definição legal de dado pessoal.

O caso do X, antigo Twitter mostrou a lacuna de forma incontestável. A plataforma coletava interações de menores brasileiros para treinar seus modelos de IA e só foi interrompida depois de uma decisão da Autoridade Nacional de Proteção de Dados. Ou seja: a proteção só apareceu depois da violação, e não como prevenção.

Outro ponto crítico é a ausência de obrigações de transparência e auditoria específicas para sistemas que interagem com crianças. Não há exigência clara de explicar como um algoritmo decide o que sugerir, nem de excluir completamente dados usados para treinar modelos. Enquanto isso, o aprendizado da IA permanece ativo, mesmo que a conta seja apagada.

Em resumo, a legislação brasileira reconhece a importância do tema, mas não acompanha a velocidade e a sofisticação da IA. Precisamos de normas que partam da lógica atual, em que o risco não é só o vazamento de dados, mas o treinamento contínuo de modelos que mapeiam e influenciam o comportamento infantil.

IA de Boa: Como equilibrar inovação tecnológica e segurança infantil, sem que uma área inviabilize a outra?

Jamille Porto:

Equilibrar inovação tecnológica e segurança infantil não é uma guerra de lados; é uma questão de como a tecnologia é criada e supervisionada. Se a proteção vier apenas depois do lançamento, sempre será tarde demais. O ponto de virada é incorporar segurança desde a concepção — o que chamamos de privacy by design — para que cada nova funcionalidade já nasça com limites claros de coleta, uso e retenção de dados.

Hoje, muitas plataformas ainda operam na lógica de “lançar primeiro, regular depois”, e é aí que o risco explode. O caso do X, antigo Twitter, obrigado a parar de usar dados de menores para treinar IA, é um alerta: só houve ação depois da violação. Em vez de reagir a cada crise, o ideal é exigir auditorias independentes, testes de impacto e explicabilidade obrigatórios antes de qualquer ferramenta interagir com crianças.

Também precisamos mudar a mentalidade do que é inovação. Avançar não é lançar recursos cada vez mais viciantes; é criar produtos que funcionem sem capturar dados além do necessário. Quando a tecnologia é pensada para proteger, ela se torna mais confiável e competitiva, não menos. Isso significa, por exemplo, limitar algoritmos que prendem a atenção infantil a qualquer custo e priorizar sistemas que respeitem o tempo e o desenvolvimento cognitivo da criança.

Em resumo, segurança não trava o progresso. Ela é o verdadeiro diferencial competitivo, porque dá às famílias confiança para usar as novidades. O equilíbrio surge quando a pergunta deixa de ser “como conciliar inovação e proteção” e passa a ser “por que ainda lançamos algo que não protege por padrão”.

IA de Boa: Se pudesse deixar uma orientação prática para famílias e educadores hoje, qual seria o primeiro passo para aumentar a segurança digital das crianças?

Jamille Porto:

Se eu tivesse que escolher um único passo, seria começar a conversar hoje mesmo com a criança sobre como a internet funciona, e não esperar um incidente para reagir. Explique, com a linguagem que ela entende, que tudo o que faz online deixa rastros: cada clique, cada like, cada mensagem. Mostre na prática, por exemplo, como um simples vídeo assistido faz a plataforma sugerir outros parecidos. Essa é a base para que ela perceba também como se sente diante do que assiste. É fundamental que pais e educadores observem se um vídeo a deixa ansiosa, assustada ou irritada, porque as plataformas não diferenciam emoções saudáveis de emoções negativas: o objetivo é apenas manter a criança conectada o máximo possível, mesmo que isso signifique alimentar medo, tensão ou tristeza para prolongar o tempo de tela.

Esse diálogo precisa ser diário, não um sermão eventual. Pergunte o que ela viu, do que gostou, se algo a deixou desconfortável. Mostre que pode contar com você em qualquer situação, sem medo de julgamento ou bronca. Em paralelo, configure as ferramentas que já existem — contas familiares, filtros etários, alertas de tempo — e explique por que elas estão lá. O objetivo é criar consciência e confiança, não apenas impor barreiras.

Confiar apenas em políticas de privacidade é ilusório. A proteção real começa quando a criança entende o jogo: que plataformas lucram com atenção e dados e que ela tem o poder de dizer não, sair ou pedir ajuda quando se sentirem desconfortáveis.

Ensinar pensamento crítico e hábitos de autodefesa digital é mais duradouro do que qualquer aplicativo de controle. Essa consciência, cultivada todos os dias, acompanha a criança para além das telas e a protege em cada nova tecnologia que surgir.

Jamille Porto encerrou agradecendo a oportunidade e destacando a urgência de ampliar esse debate:

“Fico feliz em contribuir para um debate tão urgente sobre o uso da inteligência artificial e a proteção das crianças no ambiente digital. Meu desejo é que essa matéria alcance muitas famílias, ajudando pais e responsáveis a refletirem e a adotarem cuidados concretos para fortalecer a segurança digital dos filhos. É um tema que precisa ganhar cada vez mais espaço e ser tratado com a profundidade que vocês ofereceram. Conte comigo para futuras pautas que possam orientar e conscientizar ainda mais pessoas.”

Carolina Pisano – Psicóloga clínica e jurídica, especialista em neuropsicologia e em práticas inclusivas, mestra em Educação

IA de Boa – Carolina, na sua experiência clínica, quais os principais riscos que crianças e adolescentes enfrentam ao estarem expostos sem supervisão às plataformas digitais?

Carolina Pisano – A ausência de supervisão pode expor crianças e adolescentes a riscos como o acesso a conteúdos inapropriados, o contato com pessoas mal-intencionadas, além da possibilidade de cyberbullying e exploração de dados pessoais. Também observamos impactos emocionais, como ansiedade, baixa autoestima e isolamento social, quando o uso da tecnologia não é mediado. É importante compreender que o desenvolvimento saudável depende de vínculos reais, de experiências concretas e da construção gradual da autonomia, algo que o uso excessivo e desregulado pode comprometer.

IA de Boa – Você acredita que os pais/responsáveis têm conhecimento suficiente para orientar e proteger seus filhos nesse ambiente?

Carolina Pisano – De modo geral, muitos responsáveis ainda não possuem conhecimento suficiente sobre os riscos e as estratégias de proteção digital. Isso não significa falta de cuidado, mas sim um desafio que envolve também questões sociais. Famílias de diferentes classes sociais enfrentam barreiras distintas: enquanto algumas têm maior acesso a recursos tecnológicos, mas carecem de tempo e orientação adequada, outras enfrentam a falta de acesso à informação de qualidade, o que dificulta ainda mais a mediação da vida digital dos filhos. Portanto, é essencial investir em políticas públicas de inclusão digital e em ações educativas que promovam tanto o acesso à tecnologia quanto o acesso à informação confiável, para que pais e responsáveis possam exercer esse papel de forma efetiva.

IA de Boa – Quais sinais de alerta um responsável deve observar que podem indicar que a criança está sendo impactada negativamente pelo uso da tecnologia?

Carolina Pisano – Alguns sinais merecem atenção: mudanças bruscas de humor, queda no desempenho escolar, dificuldades para dormir, isolamento das relações presenciais, irritabilidade quando o acesso à internet é limitado, e comportamentos de segredo excessivo em relação ao que fazem online. Esses indicadores podem sinalizar que o uso da tecnologia está ultrapassando o limite saudável e exigem diálogo, acolhimento e, em alguns casos, acompanhamento especializado.

IA de Boa – Na sua visão, a tecnologia pode também ser uma aliada no processo educativo e terapêutico das crianças? Como equilibrar benefícios e riscos?

Carolina Pisano – Sem dúvida, a tecnologia pode ser uma grande aliada. Temos recursos digitais que ampliam o acesso ao conhecimento, favorecem a inclusão e podem ser ferramentas terapêuticas importantes, especialmente no trabalho com crianças que apresentam necessidades específicas. O equilíbrio está no uso consciente e mediado: definir limites claros de tempo e conteúdo, promover o diálogo sobre o que é consumido e, principalmente, garantir que a tecnologia não substitua experiências essenciais da infância, como brincar, interagir presencialmente e explorar o mundo real.

IA de Boa – Que conselho você daria aos pais sobre o diálogo com os filhos em relação à segurança digital?

Carolina Pisano – Meu conselho é que o diálogo seja constante, respeitoso e aberto. Crianças e adolescentes precisam se sentir acolhidos para compartilhar o que vivem online, sem medo de punição imediata. É importante que os responsáveis conversem sobre riscos e responsabilidades de forma clara, mas também validem os interesses e conquistas que surgem nesse ambiente. Inclusive, recentemente o influenciador e youtuber Felca trouxe essa questão em pauta, ao alertar sobre a falta de supervisão de crianças e adolescentes nas plataformas digitais e sobre a adultização precoce que vem acontecendo nesse espaço. Esse comportamento tem impactado a infância de maneira significativa, muitas vezes antecipando vivências para as quais as crianças ainda não estão preparadas. Isso reforça a necessidade de diálogo e acompanhamento constante por parte das famílias, para que a tecnologia seja vivida de forma saudável, respeitando o tempo e a singularidade de cada criança.

Carolina Pisano – Muito obrigada pelo espaço e pela oportunidade! Estarei sempre à disposição para contribuir em pautas tão significativas e necessárias.

👤🤖 Entre Agentes & Gente

Nesta edição, conversamos com Rafael Castro, especialista em automações digitais. Ele fala sobre os riscos e limites das plataformas genéricas, a importância do suporte humano e a diferença que uma solução personalizada pode trazer no longo prazo.

IA de Boa – Para começar, como você enxerga a diferença entre uma automação genérica (dessas que atendem milhares de usuários ao mesmo tempo) e uma solução personalizada, criada sob medida para a realidade de uma empresa ou clínica específica?

Rafael Castro – Vai depender muito do momento do empresário. A solução personalizada sempre vai ser melhor, porque é sob medida, tem mais qualidade. Mas nem sempre o empreendedor consegue investir logo de cara. Nesses casos, uma solução mais genérica, acessível, já pode ser um bom primeiro passo. Se for possível investir em algo personalizado, ótimo. Se não, começar com um software pronto, que ele mesmo consiga programar, já é uma opção válida para dar os primeiros passos.

IA de Boa – Muitas plataformas hoje oferecem pacotes “prontos” de atendimento por IA, mas acabam deixando o cliente sem suporte humano contínuo. Na sua visão, por que o acompanhamento humano ainda é essencial mesmo em soluções tecnológicas?

Rafael Castro – O atendimento humano continua sendo essencial. A IA é complementar: resolve boa parte dos casos repetitivos, mas sempre vão existir situações específicas que precisam de um humano. Eu gosto de deixar claro para o usuário quando ele está falando com uma IA e dar a opção de acionar um humano a qualquer momento. Isso evita frustração e garante uma experiência mais humanizada, especialmente no WhatsApp, onde as pessoas esperam falar com gente de verdade.

IA de Boa – Você acredita que uma clínica ou empresa que opta por uma plataforma genérica consegue de fato manter sua identidade própria e seu padrão de atendimento? Ou isso acaba se diluindo?

Rafael Castro – É possível, sim, personalizar mesmo dentro de uma plataforma padrão, mas vai exigir mais esforço do empreendedor. Na solução personalizada, o resultado vem mais rápido e exige menos dedicação direta. Já numa plataforma genérica, o empresário precisa gastar mais tempo ajustando para deixar do jeito dele. Mas, em ambos os casos, com trabalho e atenção, dá para manter a identidade.

IA de Boa – Sabemos que toda tecnologia pode falhar. Quais riscos você vê em depender de uma plataforma massificada que atende milhões de usuários ao mesmo tempo?

Rafael Castro – Toda tecnologia falha, e esse mito de que “a automação vai rodar tudo 100% sozinha” não existe. Muitos vendem esse sonho, mas a realidade é outra. A IA ajuda a escalar o atendimento com baixo custo, mas vai ter problema: IA alucina, sistemas caem. É por isso que precisa de manutenção constante, ajustes e treinamento — tanto quanto um humano precisa de capacitação para atender bem. A vantagem da IA é o custo baixo por escala, mas não substitui a necessidade de supervisão e suporte contínuo.

IA de Boa – Do ponto de vista de negócios, qual é a diferença de valor percebido entre um atendimento personalizado e um atendimento genérico? Isso impacta diretamente a experiência do cliente final?

Rafael Castro – Com certeza impacta. Atendimento personalizado converte mais, gera mais confiança. Mas é importante lembrar: não é só porque o atendimento é humano que ele é personalizado. Um humano pode atender de forma robótica, copiando e colando mensagens padrões. Tanto o humano quanto a IA precisam ser bem instruídos — com script, programação ou prompt — para entregar uma experiência verdadeiramente diferenciada.

IA de Boa – Em termos de LGPD e segurança de dados, você acha que soluções prontas realmente conseguem atender às exigências, ou é mais seguro pensar em algo feito sob medida?

Rafael Castro – Ambas podem ser seguras, desde que cumpram as normas. É preciso avaliar os contratos, as políticas de privacidade e entender como os dados estão sendo tratados. Tanto uma solução personalizada quanto uma plataforma pronta podem atender à LGPD, mas o empresário precisa verificar se a empresa fornecedora é séria e cumpre com as exigências legais.

IA de Boa – Muitas vezes, o empresário vê o preço como fator principal e acaba escolhendo o “mais barato”. Mas, olhando para médio e longo prazo, qual é a verdadeira economia: pagar menos em uma solução genérica ou investir em algo que realmente sustente o crescimento do negócio?

Rafael Castro – No longo prazo, sempre é melhor investir em algo que sustente o crescimento, que dê menos dor de cabeça. Mas a realidade é que muitos empreendedores não conseguem começar por aí, porque a solução personalizada geralmente é mais cara. Então, tudo bem começar pelo mais acessível. O importante é, assim que for possível, migrar para algo mais sólido e confiável, que acompanhe o crescimento da empresa.

IA de Boa – Para encerrarmos, qual conselho você deixaria para quem deseja escolher uma solução de automação com segurança e que realmente faça sentido para a realidade da sua clínica ou empresa?

Rafael Castro – O principal conselho é ser pé no chão com as expectativas. Tem muito hype em cima da automação e da IA, e isso gera frustração. A IA não resolve todos os problemas de uma empresa, muito menos substitui totalmente o humano. O ideal é usar a tecnologia como complemento: para aumentar produtividade, reduzir custos e escalar o atendimento. Mas sempre com equipe humana junto, manutenção constante e escolhendo fornecedores sérios, com cases reais e know-how. É aí que a automação realmente faz sentido e traz resultados.

🤖✨ IA com Personalidade

🛰️ Ficha Técnica – Agente Start

Imagem ilustrativa – o agente é um serviço. A aparência mostrada é apenas simbólica. Na prática, cada agente é configurado de acordo com a empresa, segmento e personalidade desejada pelo cliente. Ele atua via WhatsApp e/ou Instagram Direct

Nome: Agente Start

Função principal: Captação e engajamento inicial de clientes para profissionais e negócios em fase de crescimento.

Público-alvo: Profissionais autônomos, pequenos empreendedores, consultórios recém-inaugurados, advogados, médicos, dentistas, coaches e demais áreas que precisam atrair clientes.

O que ele faz:

Conversa com fluidez por mensagens digitadas e também por áudios humanizados.

Responde automaticamente via WhatsApp e Instagram Direct, com linguagem natural.

Envia mensagens de captação personalizadas, lembretes e curiosidades que despertam interesse.

Esclarece dúvidas iniciais e coleta informações do cliente.

Direciona os contatos para fechamento de consultas, reuniões ou vendas.

Diferenciais:

Não é um chatbot comum com respostas engessadas.

Adapta-se ao tom de voz e estilo de cada cliente/empresa.

Trabalha 24h por dia, 7 dias por semana, sem faltar.

Ajuda a ganhar tempo e não perder oportunidades de novos clientes.

🔐 Segurança em Foco

Nesta edição, a coluna traz a visão de Thiago Santos, especialista em segurança digital e parceiro da IP Estratégias, que reforça a importância de não se deixar levar pelo “canto da sereia” das plataformas genéricas de atendimento médico.

- Quando uma plataforma permite que qualquer pessoa se cadastre como médico, sem verificação real, ela cria vulnerabilidades preocupantes em dois níveis: o dos dados e o da vida das pessoas.

No campo dos dados, o risco é diretamente ligado à privacidade e à segurança dos pacientes que ali serão atendidos. Sem validação de identidade, qualquer indivíduo pode se passar por profissional de saúde e ter acesso a informações clínicas altamente sensíveis. Isso significa que históricos médicos, diagnósticos, exames e até conversas íntimas podem cair nas mãos erradas, abrindo espaço para golpes, vazamentos e usos indevidos. A LGPD é clara quando classifica os dados de saúde como sensíveis, justamente porque, se expostos, podem gerar danos profundos e, na maioria das vezes, irreversíveis.

Mas há um segundo nível, ainda mais grave ao meu ver: a segurança do próprio paciente. Imagine alguém em um momento de vulnerabilidade emocional ou física, buscando ajuda, e do outro lado estar um falso profissional, sem preparo e sem responsabilidade ética. Isso pode levar a orientações equivocadas, tratamentos perigosos e, em casos extremos, colocar vidas em risco. O que deveria ser um espaço de cuidado transforma-se em território de exposição — e, pior, um ambiente fértil para a atuação de organizações criminosas.

É preciso lembrar que segurança digital não é apenas proteger sistemas — é proteger pessoas. Por trás de cada clique existe uma vida real, uma história única que deve ser protegida. Profissionais da saúde, sérios e comprometidos com o juramento que fizeram, jamais abririam mão do bem-estar de seus pacientes em nome de economia ou lucro.

Afinal, essa é uma economia que não vale a pena. O barato pode sair caro: médicos podem enfrentar indenizações pesadas por violação da privacidade, e pacientes, ainda que indenizados, carregarão a dor de terem sua intimidade exposta em uma sociedade que valoriza a imagem acima de tudo. O vazamento de informações de saúde pode destruir não apenas a confiança, mas também a forma como alguém é visto — e até como se enxerga, mas creio que isso seja um papo para uma outra coluna.

Por fim, eu gostaria de destacar que a Constituição Federal, em seu artigo 5º, garante a dignidade da pessoa humana e a inviolabilidade da vida privada. Junto da LGPD, ela forma uma base jurídica que exige rigor, transparência e responsabilidade no tratamento de dados. Por isso, a confecção de plataformas autênticas, feitas por profissionais qualificados, com processos de verificação robustos e suporte humano contínuo, não pode ser vista como detalhe ou burocracia. É a base que sustenta a confiança entre médico e paciente.

No fim das contas, a vida — e a dignidade que a acompanha — valem mais do que qualquer economia financeira. A tecnologia precisa servir à saúde como instrumento de cuidado para que não se torne uma ameaça. Porque, como lembra o juramento que ecoa há séculos, o compromisso maior da medicina é com a proteção da vida e não com o lucro.

💉 Sem Anestesia

É muito fácil “perguntar para a IA” se um serviço é bom e acreditar cegamente na resposta. O que a maioria das pessoas não sabe é que, se a pergunta é genérica, a resposta será genérica — puxada de bancos de dados e padrões prontos. Não é opinião, nem avaliação real: é estatística.

Foi isso que eu testei. Quando perguntei ao Perplexity, uma das Ias mais comentadas do momento, sobre as plataformas genéricas de saúde, ele parecia estar defendendo com unhas e dentes. Bastou eu enviar prints reais para que a resposta mudasse completamente, reconhecendo falhas sérias. Ou seja: sem contexto, vem frase pronta; com contexto, vem análise.

Muitos profissionais — não só da saúde — estão confiando em respostas genéricas de IA para 7escolher plataformas e serviços que lidam com vidas, dados sensíveis ou dinheiro. Isso é perigoso. IA não substitui discernimento humano. Ela apoia, mas precisa de condução, contexto e verificação.

As plataformas que se vendem como milagrosas e 100% automáticas muitas vezes escondem robôs travestidos de médicos, advogados, atendentes. E se nem você sabe conduzir uma IA, imagine entregar seus dados a uma que ninguém conduz?

Convite para Participar

Você já conversou com uma inteligência artificial? Foi curioso, divertido ou surpreendente? Quer contar essa história? Mande para a gente!

📌 Se você ainda não teve essa oportunidade, a gente pode proporcionar essa experiência para você. É só entrar em contato e combinar.

📩 Envie sua experiência (ou solicite a sua conversa com IA) para: [email protected]

✨ E lembre-se: se quiser saber mais sobre como agentes inteligentes podem transformar sua empresa ou até mesmo a sua rotina pessoal, a IP Estratégias está pronta para atender você.

✨ A IP Estratégias é especialista na criação de agentes inteligentes personalizados, preparados para transformar empresas e também o dia a dia das pessoas.

A inteligência artificial está mudando o mundo, e a IA de Boa está aqui para garantir que você faça parte dessa mudança — de um jeito simples, humano e cheio de boas ideias.